Quantum computing menawarkan paradigma komputasi baru yang menjanjikan kecepatan dan kemampuan berbeda dari komputer klasik. Artikel ini menjabarkan perkembangan historis, konsep teknis seperti qubit dan decoherence, platform hardware, algoritma penting, aplikasi industri, serta tantangan keamanan dan regulasi. Pembaca akan mendapat peta jelas untuk memahami peluang, hambatan, dan langkah praktis adopsi teknologi ini di tingkat riset dan industri.

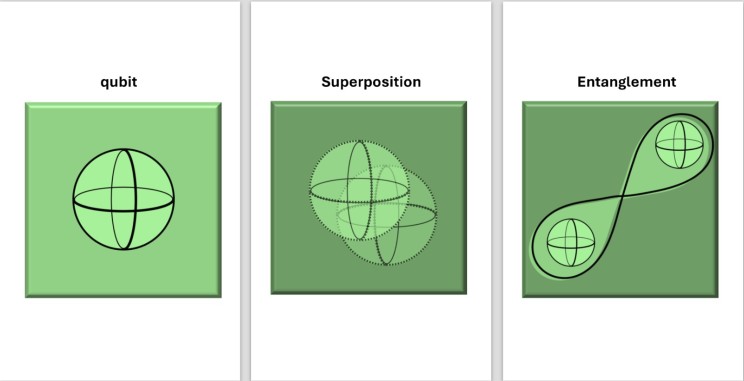

Memahami Prinsip Dasar Qubit Superposition dan Interferensi

Qubit adalah unit informasi kuantum yang, berbeda dari bit klasik yang hanya bisa bernilai 0 atau 1, dapat berada dalam kombinasi keduanya secara bersamaan. Keadaan ini disebut superposition, yang secara matematis sering ditulis sebagai |ψ⟩ = α|0⟩ + β|1⟩ dengan α dan β sebagai bilangan kompleks yang terkait dengan probabilitas hasil pengukuran. Secara intuitif, bayangkan koin yang tidak hanya menghadap angka atau gambar, melainkan berada dalam “campuran” keduanya sampai kamu benar-benar melihatnya. Saat diukur, qubit “kolaps” menjadi 0 atau 1 sesuai distribusi probabilitas tersebut.

Visualisasinya sering menggunakan Bloch sphere, yaitu bola imajiner di mana setiap titik di permukaan mewakili satu keadaan qubit. Kutub atas biasanya melambangkan |0⟩ dan kutub bawah |1⟩, sedangkan titik-titik di antaranya menggambarkan berbagai superposition dengan fase yang berbeda. Di sinilah interference berperan: operasi kuantum dapat mengatur fase sehingga beberapa kemungkinan saling menguatkan (constructive interference) dan yang lain saling meniadakan (destructive interference). Inilah mekanisme kunci yang membuat algoritma kuantum mampu “memfilter” jawaban yang diinginkan jauh lebih efisien daripada pencarian buta di komputasi klasik, dan menjadi fondasi bagi perkembangan algoritma yang akan dibahas dalam konteks sejarah dan riset berikutnya.

Visualisasinya sering menggunakan Bloch sphere, yaitu bola imajiner di mana setiap titik di permukaan mewakili satu keadaan qubit. Kutub atas biasanya melambangkan |0⟩ dan kutub bawah |1⟩, sedangkan titik-titik di antaranya menggambarkan berbagai superposition dengan fase yang berbeda. Di sinilah interference berperan: operasi kuantum dapat mengatur fase sehingga beberapa kemungkinan saling menguatkan (constructive interference) dan yang lain saling meniadakan (destructive interference). Inilah mekanisme kunci yang membuat algoritma kuantum mampu “memfilter” jawaban yang diinginkan jauh lebih efisien daripada pencarian buta di komputasi klasik, dan menjadi fondasi bagi perkembangan algoritma yang akan dibahas dalam konteks sejarah dan riset berikutnya.

💻 Mulai Belajar Pemrograman

Belajar pemrograman di Dicoding Academy dan mulai perjalanan Anda sebagai developer profesional.

Daftar SekarangSejarah dan Perkembangan Quantum Computing di Dunia

Yuri Manin

Dari sisi sejarah, ide komputer kuantum muncul ketika Yuri Manin dan Richard Feynman pada awal 1980-an menyadari bahwa sistem kuantum jauh lebih alami disimulasikan oleh mesin yang juga kuantum. Gagasan ini kemudian dirumuskan secara formal lewat model quantum Turing machine oleh David Deutsch yang menjadi fondasi teoretis bagi algoritma kuantum modern. Lonjakan besar terjadi ketika Peter Shor memperkenalkan Shor’s algorithm untuk faktorisasi bilangan besar dan Lov Grover mengusulkan Grover’s algorithm untuk pencarian lebih cepat, langsung mengguncang dunia kriptografi dan teori kompleksitas. Sejak saat itu, fokus bergeser dari “apakah mungkin?” menjadi “seberapa cepat dan skala berapa?”

Richard Feynman

Memasuki era dua ribu, investasi global melonjak dengan munculnya program besar di MIT, Caltech, ETH Zürich, hingga laboratorium nasional seperti NASA dan Los Alamos, lalu diikuti korporasi seperti IBM, Google, Microsoft, dan startup seperti IonQ dan Rigetti. Momen simbolik terjadi ketika tim Google pada dua ribu sembilan belas mengklaim quantum supremacy dengan prosesor superconducting yang menyelesaikan tugas khusus dalam hitungan menit, yang diperkirakan akan memakan waktu ribuan tahun di komputer klasik. Negara seperti Tiongkok, Uni Eropa, dan Amerika Serikat kemudian meluncurkan program miliaran dolar untuk mengejar keunggulan strategis di kriptografi, material science, dan optimisasi industri. Ritmenya mirip perlombaan luar angkasa, tetapi kali ini orbitnya adalah ruang keadaan kuantum.

Perkembangan Quantum Computing Indonesia

Di Indonesia, riset masih berada pada fase awal namun mulai terstruktur: beberapa universitas besar mengembangkan kelompok riset quantum information, quantum communication, dan simulasi kuantum berbasis cloud seperti IBM Quantum Experience. Peneliti lokal memanfaatkan platform software seperti Qiskit dan Cirq untuk merancang algoritma serta menguji prototipe di atas hardware luar negeri, sambil menjajaki kolaborasi dengan pusat riset di Asia seperti Singapura dan Jepang.

Komputer Kuantum Pertama di Indonesia dari STEI ITB

Keterbatasan dana, kurangnya cleanroom dan fasilitas kriogenik membuat pembangunan hardware mandiri berjalan lebih lambat dibanding negara maju, tetapi ini justru membuka peluang fokus pada algoritma, use case lokal, dan kebijakan. Perbedaan kecepatan adopsi akhirnya banyak ditentukan oleh skala investasi, kedalaman ekosistem talenta, serta kemampuan menghubungkan riset dasar dengan kebutuhan industri, yang akan menjadi jembatan penting menuju pembahasan arsitektur hardware di bagian berikutnya.

Arsitektur Hardware Superconductors Ion Traps dan Platform Lainnya

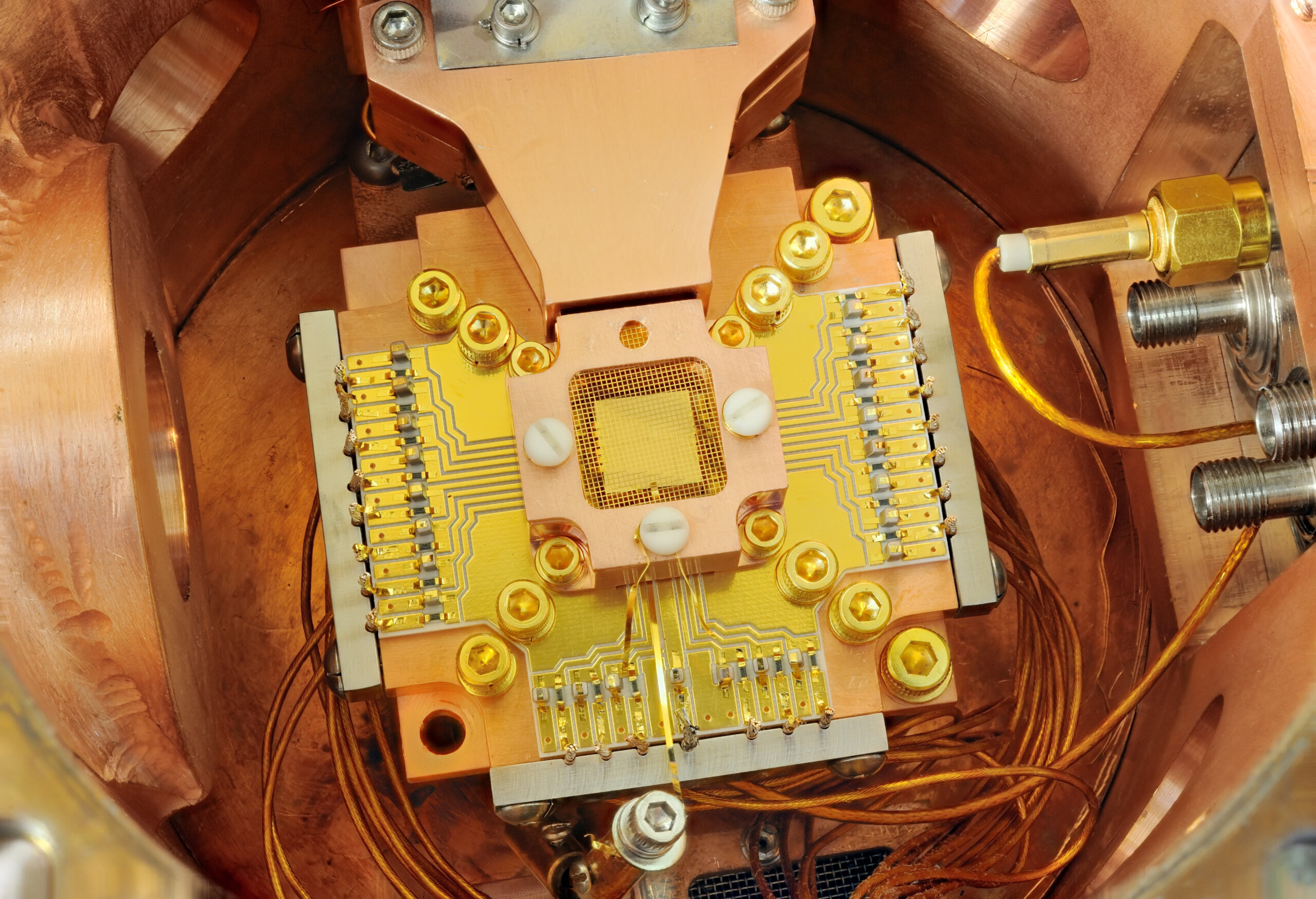

Setelah melihat sejarahnya, pertanyaan besarnya adalah: arsitektur hardware mana yang paling menjanjikan untuk melanjutkan lompatan ini? Saat ini, empat platform utama adalah superconducting qubits, trapped ions, photonic systems, dan spin qubits.

Superconducting qubits bekerja pada suhu kriogenik sangat rendah, mudah diintegrasikan dengan teknologi mikroelektronika, sehingga relatif unggul dalam skalabilitas, tetapi waktu coherence-nya lebih pendek dan sensitif terhadap kebisingan.

Trapped-ion quantum computer

Trapped ions memakai ion bermuatan yang “mengambang” dalam perangkap elektromagnetik, menawarkan coherence time sangat panjang dan fidelity gerbang tinggi, tetapi kecepatan operasi dan kompleksitas kontrol optiknya menjadi tantangan. Banyak kelompok riset global mengembangkan kedua pendekatan ini dengan ratusan qubits, sambil menguji arsitektur modular untuk memperluas skala.

Photonic systems menggunakan foton sebagai pembawa informasi, unggul untuk komunikasi jarak jauh dan beroperasi pada suhu kamar, tetapi pembuatan sumber foton tunggal yang andal dan deteksi efisien masih sulit, sehingga skalabilitas logika komputasinya menantang.

Di sisi lain, spin qubits di bahan semikonduktor atau cacat kristal memanfaatkan spin elektron atau nuklir, menawarkan potensi integrasi dengan industri chip yang sudah matang, meski kontrol presisi dan variasi proses fabrikasi masih menjadi penghambat. Di semua platform, tantangan praktis berulang: isolasi dari lingkungan, sistem cryogenics yang stabil, elektronik kontrol berfrekuensi tinggi, serta proses fabrikasi nanoskala yang konsisten.

Untuk peneliti di Indonesia, topik menarik meliputi simulasi noise dan error mitigation lintas platform, desain control electronics hemat daya, integrasi fotonik pada chip, hingga pengembangan protokol kalibrasi dan karakterisasi qubit yang dapat langsung diterapkan pada perangkat riset kolaboratif di masa depan.

Algoritma Penting Quantum Advantage dan Contoh Kasus Aplikasi

Dengan hardware seperti superconducting qubits dan ion traps, fokus beralih ke algoritma yang benar-benar memberi quantum advantage. Algoritma klasik yang paling sering dibahas adalah Shor’s algorithm untuk faktorisasi bilangan besar, yang secara teoritis mampu mematahkan skema kriptografi berbasis RSA, serta Grover’s algorithm yang memberi percepatan kuadrat untuk pencarian di ruang solusi tak terstruktur. Di sisi lain, variational quantum algorithms seperti VQE dan QAOA menggabungkan sirkuit kuantum dangkal dengan classical optimizer, sehingga lebih cocok untuk perangkat ruidi saat ini.

Quantum advantage sendiri berarti tugas tertentu dapat diselesaikan komputer kuantum secara signifikan lebih cepat atau lebih efisien dibanding algoritma klasik terbaik yang diketahui. Contoh awal adalah eksperimen random circuit sampling Google Sycamore, yang menunjukkan keunggulan pada tugas sangat spesifik namun belum langsung relevan bisnis. Aplikasi yang lebih dekat ke industri muncul pada optimisasi kombinatorial, misalnya penjadwalan logistik atau desain portofolio, di mana QAOA dibandingkan dengan simulated annealing klasik dan kadang memberi solusi serupa dengan waktu konvergensi lebih singkat pada ukuran masalah tertentu.

Quantum advantage sendiri berarti tugas tertentu dapat diselesaikan komputer kuantum secara signifikan lebih cepat atau lebih efisien dibanding algoritma klasik terbaik yang diketahui. Contoh awal adalah eksperimen random circuit sampling Google Sycamore, yang menunjukkan keunggulan pada tugas sangat spesifik namun belum langsung relevan bisnis. Aplikasi yang lebih dekat ke industri muncul pada optimisasi kombinatorial, misalnya penjadwalan logistik atau desain portofolio, di mana QAOA dibandingkan dengan simulated annealing klasik dan kadang memberi solusi serupa dengan waktu konvergensi lebih singkat pada ukuran masalah tertentu.

Pada simulasi material dan kimia, VQE digunakan untuk menghitung energi dasar molekul kecil, lalu dibandingkan dengan metode klasik seperti CCSD(T); saat ini presisinya kompetitif untuk sistem kecil namun belum mengalahkan skala metode klasik. Di ranah quantum machine learning, quantum kernel methods dan parameterized quantum circuits dieksplorasi untuk klasifikasi data berstruktur kompleks, walau klaim keunggulan praktis masih banyak diuji ulang. Untuk memilih algoritma, kamu perlu memetakan jenis masalah: faktorisasi dan kriptografi pasca-kuantum terkait Shor, pencarian tak terstruktur cocok dengan Grover, optimisasi kombinatorial untuk QAOA, dan masalah struktur elektronik untuk VQE. Batasan saat ini adalah jumlah qubit yang terbatas, noise, serta kebutuhan error mitigation, yang akan mengantar pada pembahasan tantangan decoherence, error correction, dan skalabilitas di bagian berikutnya.

Tantangan Teknikal Decoherence Error Correction dan Skalabilitas

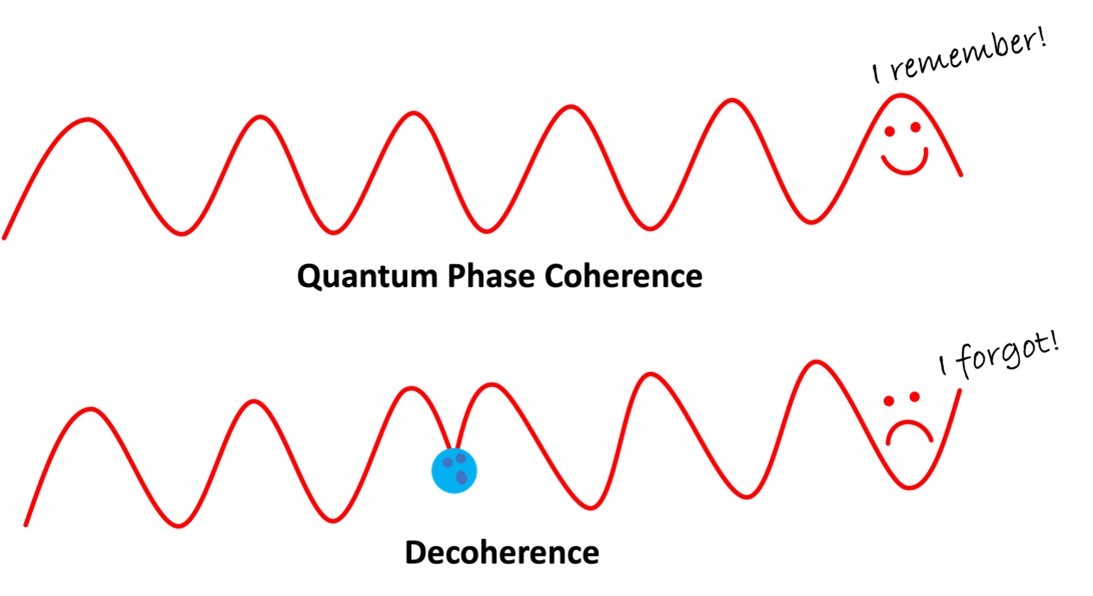

Algoritma yang menjanjikan quantum advantage langsung berbenturan dengan realitas pahit: decoherence, noise acak, dan kesalahan sistematik pada kalibrasi gate. Qubit fisik mudah sekali “lupa” keadaannya akibat interaksi dengan lingkungan, sementara kesalahan kecil yang terakumulasi di setiap gate membuat perhitungan panjang menjadi tidak dapat dipercaya. Karena itu, fokus riset bergeser dari sekadar menambah jumlah qubit ke bagaimana menjaga kualitasnya dalam skala besar.

Algoritma yang menjanjikan quantum advantage langsung berbenturan dengan realitas pahit: decoherence, noise acak, dan kesalahan sistematik pada kalibrasi gate. Qubit fisik mudah sekali “lupa” keadaannya akibat interaksi dengan lingkungan, sementara kesalahan kecil yang terakumulasi di setiap gate membuat perhitungan panjang menjadi tidak dapat dipercaya. Karena itu, fokus riset bergeser dari sekadar menambah jumlah qubit ke bagaimana menjaga kualitasnya dalam skala besar.

Di sinilah quantum error correction berperan: informasi disimpan dalam logical qubit yang dibangun dari banyak qubit fisik menggunakan stabilizer codes seperti surface codes. Pendekatan ini membutuhkan overhead besar, bisa puluhan hingga ratusan qubit fisik per satu logical qubit, tetapi menawarkan fault-tolerance jika error rate di bawah ambang tertentu. Tantangannya, sistem berskala ratusan ribu qubit fisik berarti integrasi, interkonektivitas, dan elektronik kontrol klasik harus dirancang ulang agar tetap stabil sekaligus hemat daya.

Berbagai pendekatan sedang dieksplorasi: material superkonduktor baru, teknik fabrikasi 3D, hingga arsitektur modular dengan banyak QPU yang dihubungkan lewat quantum interconnect. Untuk menilai kemajuan, beberapa metrik penting perlu dipantau seperti physical error rate per gate, coherence time, logical error rate, serta quantum volume dan ukuran sirkuit terbesar yang bisa dijalankan secara andal. Indikator inilah yang nantinya menentukan kapan perangkat keras cukup matang untuk mengeksekusi skema kriptografi baru dan strategi keamanan di era post-quantum.

Implikasi Keamanan Kriptografi Post Quantum dan Rekomendasi Kebijakan

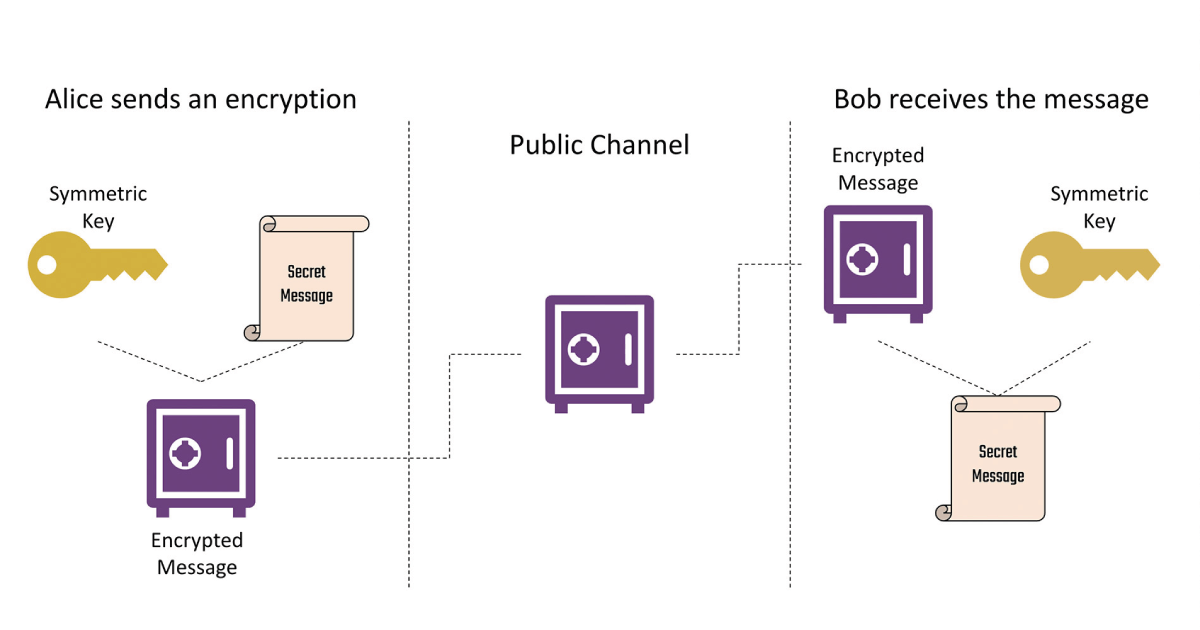

Begitu fault-tolerant quantum computer berskala besar tersedia, skema klasik seperti RSA dan Elliptic Curve Cryptography praktis runtuh karena serangan Shor’s algorithm. Ancaman ini belum hadir secara operasional hari ini, tetapi data yang disimpan sekarang bisa direkam lalu didekripsi di masa depan (harvest now, decrypt later), sehingga risikonya bersifat strategis. Di sinilah konsep Post-Quantum Cryptography (PQC) masuk: algoritma kriptografi berbasis masalah matematika yang diyakini tahan terhadap serangan quantum, seperti keluarga CRYSTALS-Kyber dan CRYSTALS-Dilithium yang sedang distandarkan NIST.

Post-Quantum Cryptography (PQC)

Bagi pemerintah dan industri, langkah awal yang realistis adalah melakukan crypto inventory: memetakan di mana saja RSA, ECC, dan protokol lama dipakai, lalu menyusun rencana migrasi bertahap ke protokol hybrid yang menggabungkan kripto klasik dan PQC. Kebijakan pengadaan perlu mensyaratkan dukungan quantum-safe, pembaruan reguler mengikuti standar internasional, serta kewajiban crypto-agility agar algoritma bisa diganti tanpa merombak sistem. Pengembang TI dapat mulai menguji library PQC di lingkungan staging, memperbarui protocol negotiation, dan mengintegrasikan uji keamanan ke dalam CI/CD pipeline, sementara manajemen risiko memasukkan skenario serangan quantum ke dalam analisis threat modeling. Untuk kesiapan nasional, dibutuhkan kolaborasi riset kampus–industri, program pendidikan keamanan quantum-aware, serta investasi infrastruktur PKI dan pusat data yang siap mendukung standar PQC generasi berikutnya.

Penutup

Perjalanan perkembangan quantum computing masih panjang namun menjanjikan transformasi besar pada kriptografi, material science, dan optimisasi. Dengan memahami dasar teknis, tantangan hardware, dan kebijakan, pembuat kebijakan dan praktisi dapat merencanakan investasi riset serta kesiapan keamanan. Artikel ini memberikan panduan langkah awal: kolaborasi riset, penguatan ekosistem, dan kebijakan adaptif untuk manfaat maksimal.