BigQuery menawarkan kemampuan Partitioning dan Clustering yang bisa menurunkan biaya dan mempercepat query pada dataset besar. Artikel ini menjelaskan langkah 0→1 untuk merancang, mengimplementasi, dan mengoptimalkan partisi dan klaster agar biaya storage dan query lebih efisien.

Fokus pada desain skema, contoh SQL, taktik pengukuran biaya, dan checklist migrasi praktis untuk tim data engineer.

Memahami Konsep Partitioning untuk Data Analitik Skala Besar

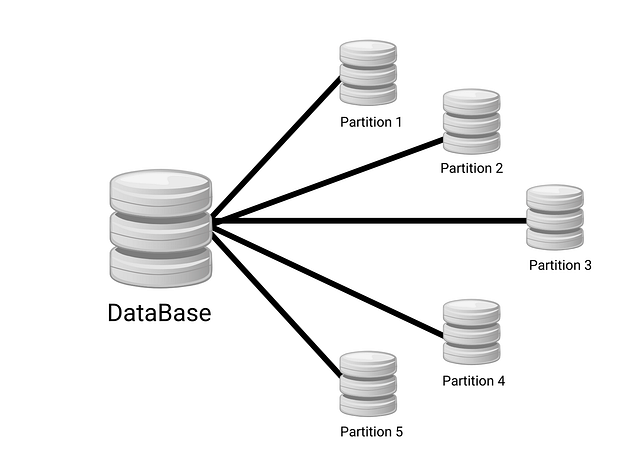

Partitioning adalah teknik memecah tabel besar menjadi potongan logis sehingga query dan pemeliharaan menjadi lebih efisien; ini berbeda dengan sharding yang mendistribusikan data ke node atau server berbeda untuk skala horizontal. Pada data warehouse tujuan utama adalah mengurangi work set saat mengeksekusi query, sementara sharding fokus pada kapasitas dan isolasi beban. Bayangkan rak arsip: partitioning menata dokumen per folder di satu rak; sharding memecah rak ke ruangan lain.

💻 Mulai Belajar Pemrograman

Belajar pemrograman di Dicoding Academy dan mulai perjalanan Anda sebagai developer profesional.

Daftar Sekarang

Jenis umum adalah range, ingestion-time, dan hash. Range cocok untuk kolom tanggal seperti order_date; ingestion-time pas untuk log yang ditulis terus-menerus; hash membantu distribusi seragam pada key seperti user_id. Pilih berdasarkan pola query dan pola tulis.

Partition pruning bekerja dengan mengecualikan partition yang tidak relevan saat perencanaan query sehingga hanya membaca partition yang diperlukan. Karena sistem seperti BigQuery dan Snowflake menagih berdasar bytes scanned, pruning langsung menurunkan cost dan mempercepat respons. Jadi desain partition yang selaras dengan filter utama berarti penghematan nyata.

Keuntungan: query targeted lebih cepat dan biaya turun. Trade‑off: latency insert bisa meningkat, muncul hot-spot jika semua tulis ke satu partition, dan metadata overhead untuk banyak partition. Hindari partition bila tabel kecil atau bila full scan terjadwal dan murah.

- Pilih range untuk analytic time-series; gunakan hash untuk sebaran key yang merata.

- Prioritaskan kolom yang sering dipakai di WHERE untuk pruning efektif.

- Hitung estimasi bytes scanned sebelum produksi untuk validasi cost.

- Jika ragu, mulai dengan coarser partition lalu refine setelah observasi.

|

1 2 3 4 5 6 7 8 9 |

-- Contoh PostgreSQL: partition by range pada kolom order_date CREATE TABLE orders ( id BIGINT, order_date DATE, amount NUMERIC ) PARTITION BY RANGE (order_date); CREATE TABLE orders_2025_q1 PARTITION OF orders FOR VALUES FROM ('2025-01-01') TO ('2025-04-01'); |

Desain Partisi Berdasarkan Timestamp dan Range yang Efisien

Pilih granularitas DAY, HOUR, atau MONTH berdasarkan volume, pola query, dan retention: granularitas lebih halus mempercepat query waktu-nyata tetapi menambah metadata dan overhead, sedangkan granularitas kasar mengurangi partisi tetapi bisa memaksa full-scan. Pertimbangkan: berapa sering query memfilter rentang waktu dan berapa banyak data yang masuk per satuan waktu.

Ingestion-time versus column-based partitioning memiliki implikasi penting pada late-arrival. Ingestion-time cepat untuk pipeline streaming, tapi data yang datang terlambat bisa berada di partisi salah. Sebaliknya, partisi berdasarkan kolom waktu event menjaga konsistensi historis.

Strategi untuk late data: tulis ke staging atau gunakan flag write time sementara lalu lakukan backfill ke partisi event-time; gunakan tombstones untuk delete-log sebelum kompaksi. Buat workflow terjadwal yang menjalankan verifikasi dan re-partition untuk data terlambat.

Atur partition expiration untuk menurunkan biaya. Contoh: bila tabel menghasilkan sepuluh GB per hari, retention tiga puluh versus sembilan puluh hari berarti penghematan ruang sebesar enam ratus GB; dengan biaya penyimpanan dua sen per GB per bulan, hemat sekitar dua belas dolar per bulan.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 |

-- BigQuery: partition by event date, expire setelah 30 hari CREATE TABLE dataset.events ( event_id STRING, event_ts TIMESTAMP, payload STRING ) PARTITION BY DATE(event_ts) OPTIONS(partition_expiration_days=30); -- Hive: partition by dt (yyyy-MM-dd) dan backfill manual CREATE TABLE events (event_id STRING, payload STRING) PARTITIONED BY (dt STRING); ALTER TABLE events ADD PARTITION (dt='2025-10-01') LOCATION '/data/events/2025-10-01'; |

Maintenance: jalankan compaction multi-partition untuk mengurangi file kecil, jadwalkan penghapusan partisi lama, dan simpan backup snapshot sebelum drop. Checklist migrasi berikutnya harus mencakup estimasi biaya, pengujian backfill, dan pemantauan retention.

Strategi Clustering untuk Mempercepat Query dan Mengurangi Biaya

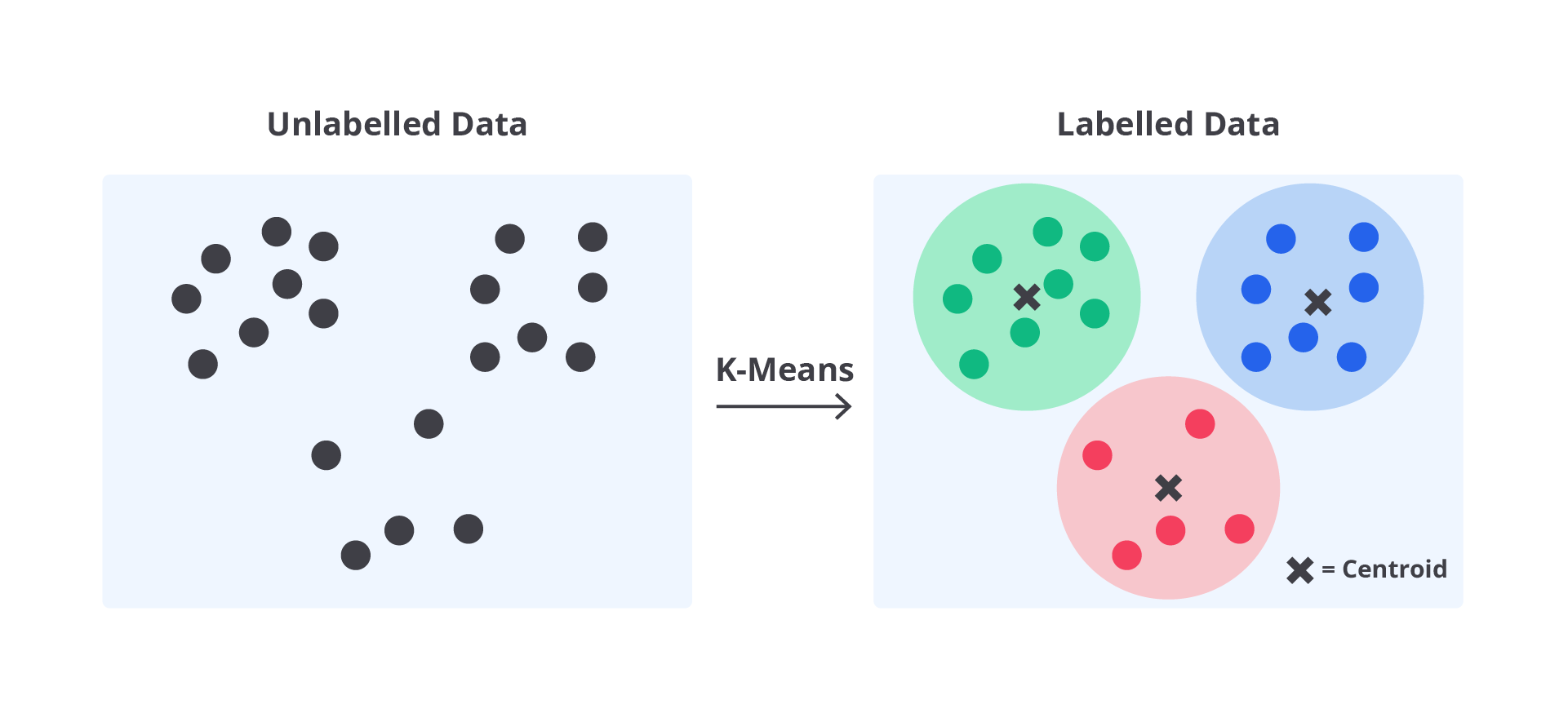

Clustering mengelompokkan data secara fisik berdasarkan kolom sehingga query dengan filter pada kolom tersebut membaca lebih sedikit blok; berbeda dengan partitioning yang memisah data berdasarkan rentang atau waktu. Pilih clustering key berdasarkan cardinality yang sedang-tinggi, pola akses (kolom yang sering ada di WHERE atau GROUP BY), serta kolom yang secara statistik memotong data secara signifikan; hindari kolom boolean atau yang sangat jarang digunakan.

Praktik umum: partisi dulu (misalnya: tanggal), lalu cluster di dalam partisi menggunakan sampai empat kolom sebagai batasan maksimal. Untuk data dengan banyak DML atau streaming, pahami bahwa penataan ulang tidak selalu instan; strategi re-cluster yang aman adalah menulis ulang partisi dengan CREATE OR REPLACE TABLE AS SELECT batch terjadwal.

Praktik umum: partisi dulu (misalnya: tanggal), lalu cluster di dalam partisi menggunakan sampai empat kolom sebagai batasan maksimal. Untuk data dengan banyak DML atau streaming, pahami bahwa penataan ulang tidak selalu instan; strategi re-cluster yang aman adalah menulis ulang partisi dengan CREATE OR REPLACE TABLE AS SELECT batch terjadwal.

Query yang mendapat manfaat tipikalnya memiliki predikat pada kolom cluster (mis. user_id atau country) dan rentang partisi; query tanpa filter selektif tetap memindai banyak data sehingga tidak diuntungkan. Ukur efektivitas lewat benchmark sebelum/sesudah: catat bytes processed, latency, dan persentase partisi yang dipindai; targetkan penurunan bytes sebagai KPI.

|

1 2 3 4 |

CREATE TABLE dataset.events PARTITION BY DATE(event_time) CLUSTER BY user_id, country AS SELECT * FROM dataset.raw_events; |

Optimasi Storage dan Query Pada bigquery untuk Hemat Biaya

Biaya pada BigQuery terdiri dari beberapa komponen: biaya storage (aktif dan long‑term), biaya query bytes processed pada model on‑demand, biaya slots untuk flat‑rate, serta biaya untuk streaming inserts. Memahami proporsi tiap komponen membantu memprioritaskan optimasi; kadang mengurangi bytes scanned jauh lebih efektif daripada memotong storage kecil‑kecilan.

Cara konkret mengurangi bytes scanned: selalu filter pada partitioning, pilih kolom spesifik alih‑alih menggunakan SELECT *, dan gunakan clustering untuk data yang sering dipakai bersama. Untuk beban baca berulang, pertimbangkan materialized view; sedangkan keputusan antara denormalization dan normalization adalah trade‑off antara storage tambahan dan berkurangnya bytes yang diproses.

Contoh sederhana: sebelum optimasi sebuah job memindai lima TB per hari (lima × biaya per TB). Jika optimasi menurunkan pemindaian menjadi satu TB per hari, biaya query turun sekitar lima kali lipat; pengaruhnya langsung terlihat di tagihan bulanan dan latency query.

|

1 2 3 4 5 6 7 |

CREATE TABLE dataset.events PARTITION BY DATE(event_timestamp) CLUSTER BY user_id, event_type OPTIONS(partition_expiration_days = 90, expiration_timestamp = TIMESTAMP_ADD(CURRENT_TIMESTAMP(), INTERVAL 365 DAY)); -- Materialized view example CREATE MATERIALIZED VIEW dataset.mview_events AS SELECT user_id, event_type, COUNT(*) AS cnt FROM dataset.events WHERE event_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 30 DAY) GROUP BY user_id, event_type; |

- Checklist pre‑deployment: lakukan cost estimation untuk query utama, jalankan test query pada subset, tetapkan baseline monitoring, set table expiration dan partition expiration, pilih ingest batch bila mungkin untuk kurangi streaming inserts.

Monitoring Biaya, Statistik Partisi, dan Alerting Praktis

Pantau metrik utama: bytes scanned per query, cost per day, partition size, query latency, dan slot utilization. Data ini memberi gambaran cepat area paling boros biaya dan titik optimasi yang berpengaruh. Anggap metrik seperti panel kontrol kendaraan: kalau indikator panahnya menyala, segera cek mesin query yang memindai terlalu banyak data.

Ambil statistik partisi dan ukuran tabel lewat INFORMATION_SCHEMA. Contoh sederhana untuk laporan harian partisi dan bytes scan per query:

|

1 2 3 4 5 6 7 8 9 |

SELECT table_name, partition_id, total_rows, size_bytes FROM `your_project`.`your_dataset`.INFORMATION_SCHEMA.PARTITIONS ORDER BY size_bytes DESC; SELECT DATE(creation_time) AS day, SUM(total_bytes_processed) AS bytes_scanned, COUNT(*) AS query_count FROM `region-us`.INFORMATION_SCHEMA.JOBS_BY_PROJECT WHERE job_type='QUERY' AND state='DONE' AND DATE(creation_time) BETWEEN DATE_SUB(CURRENT_DATE(), INTERVAL 7 DAY) AND CURRENT_DATE() GROUP BY day ORDER BY day; |

Set up alerting untuk ambang biaya, lonjakan tiba-tiba (misal dua kali lipat dari rata-rata), dan anomali pertumbuhan partisi. Otomasi rekomendasi: temukan tabel besar tanpa partisi dengan kolom partitioning_type kosong lalu sarankan partitioning berdasarkan kolom tanggal yang sering dipakai dalam filter. Proses review rutin: frekuensi mingguan untuk tim data engineering, eskalasi ke arsitek jika biaya melebihi ambang, dan runbook singkat — identifikasi query, batalkan bila perlu, terapkan predicate atau clustering sementara, lalu jadwalkan perubahan skema. Langkah ini menyiapkan analisis biaya skema pada bab selanjutnya.

Kasus Penggunaan Contoh Skema Dan Perbandingan Biaya Implementasi

Untuk empat skenario nyata—analytics event log, IoT time series, access logs, dan billing data—rekomendasi umum: partitioning berdasarkan waktu (DATE/TIMESTAMP) dan clustering pada key selektif yang sering digunakan di WHERE (mis. user_id, device_id, status). Pendekatan ini mengurangi scan dan mempercepat agregasi.

- Analytics event log: PARTITION BY DATE(event_time) + CLUSTER BY user_id,event_type.

- IoT time series: PARTITION BY DATE(ts) + CLUSTER BY device_id,sensor_type.

- Access logs: PARTITION BY DATE(request_time) + CLUSTER BY host,status.

- Billing data: PARTITION BY DATE(bill_date) + CLUSTER BY account_id,region.

|

1 2 3 |

CREATE TABLE dataset.analytics_events ( event_time TIMESTAMP, user_id STRING, event_type STRING, payload JSON ) PARTITION BY DATE(event_time) CLUSTER BY user_id,event_type; |

Contoh estimasi: sebelum optimasi table scan 30 TB/bulan (estimasi biaya $150), setelah: 5 TB/bulan ($25) — storage berubah minor; angka ini hanya ilustrasi untuk perbandingan.

- Checklist migrasi 0→1: audit schema, desain partition/cluster, plan backfill, validation queries, cutover, rollback plan.

- Risiko & mitigasi: data skew (rehash keys), late arrival (buffer partitions), query regressions (AB test), selalu lakukan load/perf testing sebelum cutover.

Penutup

Setelah membaca, pembaca akan punya peta langkah konkret untuk mengurangi biaya menggunakan Partitioning dan Clustering di lingkungan data besar. Terapkan desain partisi yang sesuai, pilih clustering key yang relevan, lakukan cost estimation dan monitoring secara berkala. Hasilnya: query lebih cepat, biaya turun, dan operasional lebih mudah untuk skala produksi. Gunakan checklist migrasi yang disajikan untuk memulai.